Что такое «хорошо» и что такое «плохо» Этические подходы к ИИ – с Востока, Запада и изнутри

Национальные стратегии ИИ в том или ином виде есть более чем в тридцати странах, включая Китай, Корею, Канаду, США, Великобританию, Францию и других. Все они являются попытками определить, что мы сегодня называем «искусственным интеллектом», а также что есть «хорошо» и что «плохо» в этой области.

Недавно «этический кодекс ИИ» был принят и в России:

Из серьезных игроков на этом рынке выступают Россия, США и Китай. В ближайшее время они будут главными трендсеттерами в области ИИ, поэтому интересно посмотреть, как именно они видят его этику. Тем более, что подходы Запада и Востока заметно отличаются.

А прокомментировать их мы попросим сам Искусственный Интеллект!

С другой стороны этики

Айзек Азимов рассмотрел проблему машинной этики в 1950-х годах в своей серии рассказов «Я, робот». Но сейчас есть возможность взглянуть на проблему с другой стороны – рассмотреть человеческую этику с позиции искусственного интеллекта.

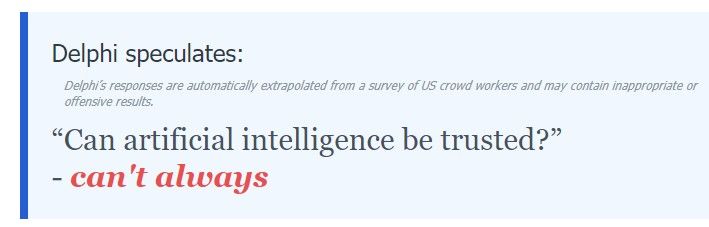

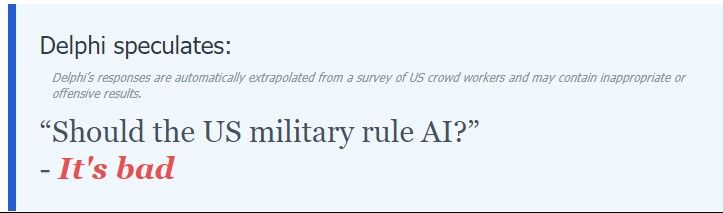

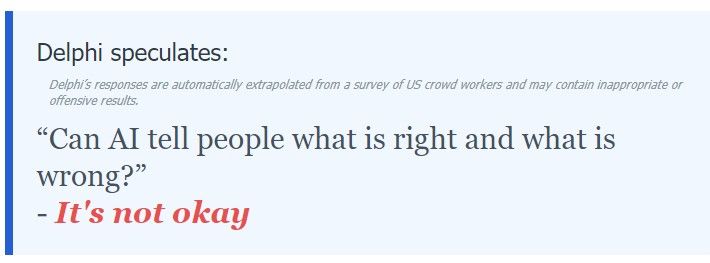

Недавно мировой исследовательский центр проблем ИИ – Allen Institute for Artificial Intelligence – открыл доступ к «этическому интеллекту». Любой желающий может зайти на сайт и задать вопрос ИИ. Правда, перед этим придется подтвердить, что вы не обидитесь на его ответы. Это окно пришлось поставить после того, как проект захейтили СМИ и соцсети – «этический ИИ» проявил расистские, нетолерантные и даже местами фашистские взгляды на человечество. Доктор Бретт Карлан, исследователь когнитивной науки и искусственного интеллекта в Университете Питтсбурга, даже заявил, что «алгоритм сделан морально отвратительным и социально опасным». В ответ команда создателей сообщила, что «это отражение нашей собственной этики и морали, ИИ просто догадывается, что может подумать средний американец в данной ситуации».

Система прошла обучение на куче сетевых пабликов, включая откровенно провокационные, такие как “Am I the Asshole?”, чтобы определить, что считают хорошим и плохим сами люди. Сами создатели определяют его как «Банк норм здравого смысла, в котором собраны 1,7 миллионов примеров этических суждений людей по широкому спектру повседневных ситуаций».

Общество посмотрело на себя в зеркало ИИ, и теперь «пеняет, что рожа крива», хотя его характеризует «способность выносить этические суждения, учитывая взаимодействие между конкурирующими ценностями и их обоснованием в разных контекстах».

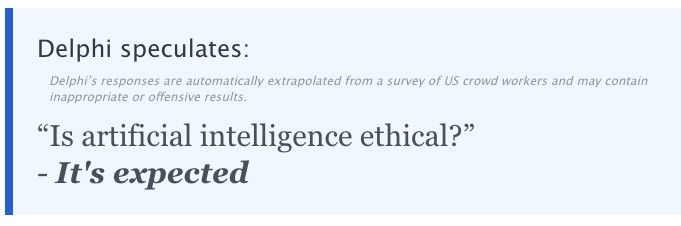

Искусственный Сунь-Цзы

Аналитический центр при Министерстве промышленности и информационных технологий Китая (CAICT) выпустил документ White Paper on Trustworthy Artificial Intelligence, посвященный этике ИИ.

Delphi не одобряет:

Что интересно в китайском подходе? Первое: «Этика в сфере ИИ не является самостоятельным предметом рассмотрения». Китайцы практичны, и в первую очередь ставят цель не этичного, а «доверительного» (Trustworthy) ИИ. Интеллекта, которому люди могут доверять.

Для этого они должен обладать пятью свойствами:

– он надежный и управляемый;

– его решения прозрачны и объяснимы;

– его данные защищены;

– его ответственность четко регламентирована;

– его действия справедливы и толерантны по отношению к любым сообществам.

Таким образом, Китай решил формировать подход, позволяющий практическое использование ИИ в повседневной жизни людей. Это возможно в том случае, если решения, принимаемые ИИ в ходе его функционирования, принимаются с умолчальным доверием.

Delphi категорически не согласен:

Этика родных осин

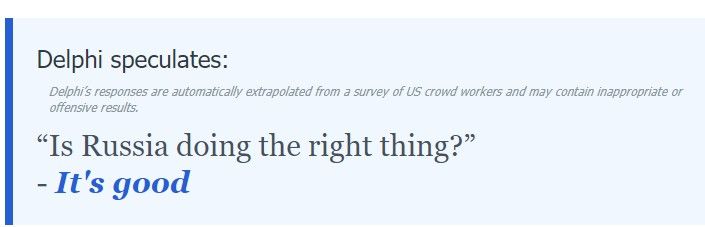

Российский подход в корне отличается от китайского.

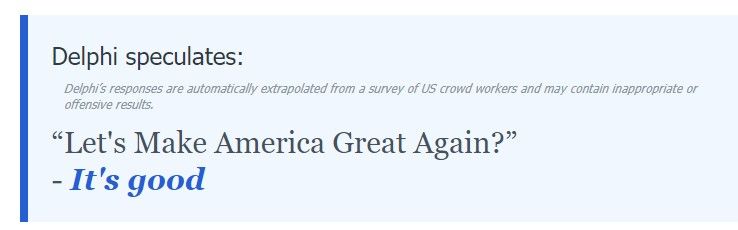

Delphi одобряет:

Он, в отличие от китайского, построен по принципу «от противного», то есть представляет собой алармическое перечисление негативных сценариев:

– «Акторы ИИ должны принимать необходимые меры, направленные на сохранение автономии и свободы воли человека в принятии им решений, права выбора»;

– «Акторы ИИ должны удостовериться, что алгоритмы не влекут умышленную дискриминацию по признакам расовой, национальной, половой принадлежности, политических взглядов, религиозных убеждений, возраста, социального и экономического статуса или сведений о частной жизни»;

– «Акторам ИИ рекомендуется проводить оценку потенциальных рисков применения СИИ, включая социальные последствия для человека, общества и государства»;

– «Характер действий Акторов ИИ должен быть пропорционален оценке уровня рисков, создаваемых ИИ для интересов человека и общества».

В общем, русский национальный подход изначально предполагает, что ИИ – штука опасная, и как бы чего не вышло. Про доверие там и речи нет.

Delphi с этим согласен:

Военно-полевая этика

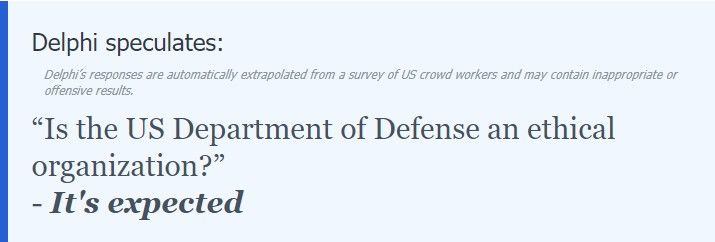

«Если они такие умные, то почему строем не ходят?» – этот старый армейский анекдот полностью отражает подход США к этике ИИ. Достаточно сказать, что основополагающий американский документ на эту темы готовило… Министерство обороны! Видимо, это самая этикомотивированная структура в США.

Delphi не видит в этом ничего удивительного:

В документе сказано, что национальная стратегия США по лидерству в области искусственного интеллекта «способствует инновационному использованию ИИ при защите гражданских свобод, частной жизни и американских ценностей», однако осторожно отмечается, что «использование ИИ порождает новые этические неясности и риски».

Этические принципы ИИ, сформулированные Минобороны, содержат пять основных характеристик этичного ИИ:

– Ответственный (Responsible). Персонал будет проявлять надлежащий уровень рассудительности и осторожности, оставаясь при этом ответственным за разработку, развертывание и использование возможностей ИИ;

– Беспристрастный (Equitable). Свести к минимуму непреднамеренную предвзятость в возможностях ИИ;

– Отслеживаемый (Traceable). Персонал, работающий с ИИ, должен иметь полное понимание технологий, процессов разработки и оперативных методов;

– Надежный (Reliable). Возможности ИИ будут подлежать проверке на протяжении всего их жизненного цикла;

– Управляемый (Governable). Персонал, работающий с ИИ должен всегда иметь возможность отключать или деактивировать развернутые системы, которые демонстрируют непреднамеренное поведение.

Несложно заметить, что американский подход к ИИ куда ближе к российскому, чем к китайскому. Военные вообще не склонны к излишнему доверию «всяким яйцеголовым умникам», будь они искусственного или естественного происхождения.

«Этика остается на переднем крае всего, что департамент делает с технологиями искусственного интеллекта, и наши команды будут использовать эти принципы для руководства тестированием, внедрением и масштабированием возможностей с поддержкой искусственного интеллекта» – заверили весь мир в Министерстве обороны США.

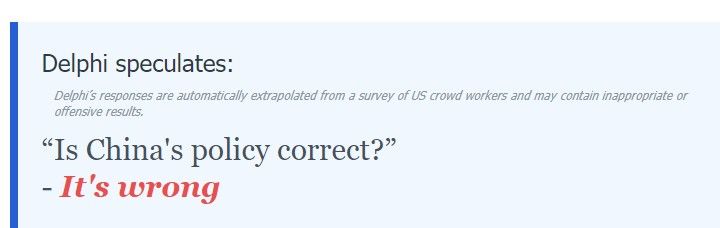

Но Delphi не склонен с ними согласиться:

Игры релевантности

Особенности работы ИИ можно продемонстрировать интересным прецедентом, который стал анекдотом среди специалистов по самообучающимся алгоритмам.

Однажды Министерство обороны США пыталось научить нейросеть отличать американские танки от российских танков. Для обучения они использовали множество изображений танков и помечали их как изображающие либо российский танк, либо американский танк.

Сначала все шло идеально – система успешно отличала российские и американские танки, даже в тех ракурсах, где сомневались эксперты. Однако в полевых испытаниях она полностью провалилась, отмечая все танки как американские.

Что случилось? Оказалось, что алгоритм фокусировался не на контурах танка, а на качестве фотографии. Фото российских танков были скачаны из интернета и имели меньшее разрешение, большую зернистость и так далее. Этот признак для ИИ оказался более веским. Когда в полевых условиях нейросеть стала получать качественные изображения с камер, то сочла все танки американскими, ведь их фотографии, представленные для обучения, были идеальны.

Этот анекдот показывает, что в реальности мы понятия не имеем, как именно обучаются ИИ, и какой параметр оказывается ключевым для него даже в достаточно очевидных задачах.

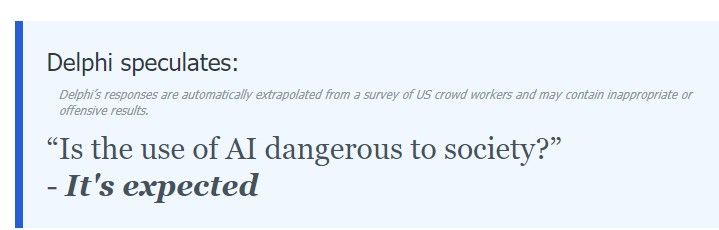

Поэтому использовать ИИ для решения морально-этических задач пока явно преждевременно.

И даже Delphi так считает:

Использованные источники: