Признаки обмана FakeCatcher и 8 других детекторов для автоматической идентификации дипфейков

Даже Шерлок Холмс не смог бы на глаз отличить дипфейк от реального видео. Поймать машину на лжи под силу только другой машине. Список таких разработок представили в свежем отчете Роскомнадзор и Государственный радиочастотный центр. «Цифровой океан» рассказывает о них подробнее.

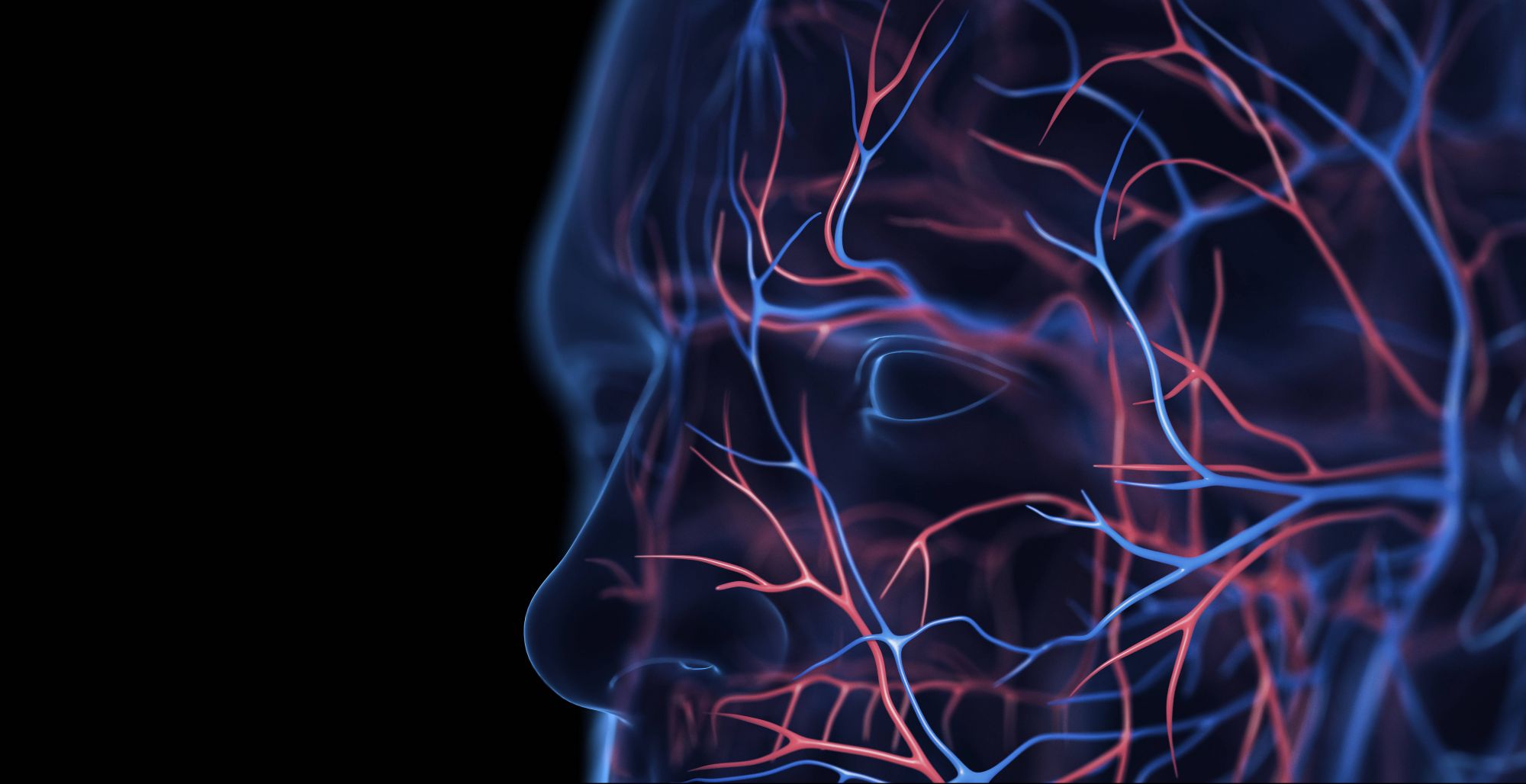

Пульсация вен

Разработчик: Intel

Готовность: разработка завершена в ноябре 2022 года, но ПО пока не открыто для коммерческого использования

Детектор FakeCatcher, разработанный Intel при поддержке Бингемтонского университета (штат Нью-Йорк), выявляет дипфейки, опираясь на цветовые пульсации подкожных вен лица. Детектор фиксирует незаметные глазу изменения тона, переводит их в цветовую карту и определяет, настоящий человек на видео или подделка. Для распознавания были разработаны новые подходы к обработке результатов медицинской фотоплетизмографии — регистрации изменений, возникающих при наполнении мелких сосудов кровью в зависимости от фазы кардиоцикла. FakeCatcher был протестирован на множестве видеороликов и показал точность работы 93–97 %.

В отличие от аналогов, которые требуют загрузки полного видео для анализа, что может занять несколько часов, FakeCatcher работает в режиме реального времени. Технология делает возможным анализ видео на подделку в видеочатах, модерацию видео в соцсетях и оперативную проверку материалов для новостных площадок.

Примечательно, что разработка Intel опирается на инструментарий, доступный бесплатно всем желающим. Это система распознавания лиц OpenFace, библиотека алгоритмов машинного зрения OpenCV и популярный фреймворк для создания нейронных сетей Keras.

Артефакты изображения

Разработчик: Sensity

Готовность: работает

Компания Sensity разработала онлайн-платформу для автоматической идентификации дипфейков. Пользователь отправляет ссылку или загружает видеофайл, а искусственный интеллект проводит анализ. Система работает хотя и не в реальном времени, но очень быстро — проверка чаще всего занимает не более секунды.

Принцип работы платформы заключается в анализе кадров изображения на основе собственной базы, которая содержит несколько миллионов изображений, определенных как «сгенерированные». Система натренирована на поиск характерных артефактов, оставляемых генеративно-состязательными нейросетями. Сравнение картинки с заведомо поддельными позволяет определить характерные для дипфейков паттерны. Поскольку сейчас именно генеративно-состязательные нейросети являются основным инструментом создания дипфейков, точность работы платформы Sensity достаточна для большинства случаев.

Сомнительные кадры

Разработчик: Zemana

Готовность: работает

Открытый проект Deepware Scanner доступен как в веб-версии, так и в виде свободного кода на GitHub, а также имеет общедоступный API (Application Programming Interface — программный интерфейс приложения), позволяющий подключать его к любым сторонним приложениям. Это позволяет разработчикам привлечь для доработки инструмента максимальное количество участников.

Deepware Scanner представляет собой сверточную нейронную сеть (специальная нейросетевая архитектура, нацеленная на распознавание образов), основанную на классификаторе изображений EfficientNet B7. Его особенность — низкая стоимость обучения моделей и простой процесс масштабирования, что позволило сделать проект свободным.

Для обучения нейросети Deepware Scanner использовался открытый датасет ImageNet, содержащий более 14 млн аннотированных изображений, и датасет Facebook DFDC (Deepfake Detection Challenge), состоящий из 120 тыс. видео.

Алгоритм работы системы покадровый, скорость — один кадр в секунду, так что использовать ее в реальном времени не получится, однако для выявления дипфейков это необязательное требование. Нейросеть анализирует кадр, определяет зону, содержащую лицо человека, очищает ее от шума, затем производит оценку вероятности, что лицо сгенерировано. На выходе пользователь получает кадры, подтверждающие наличие дипфейка, а также оценочную степень уверенности нейросети.

Микроколебания цвета

Разработчик: «Сбер»

Готовность: запатентовано в августе 2022 года, степень готовности неизвестна

«Сбер» активно продвигает биометрические технологии, которые потенциально являются одной из главных целей дипфейк-атак. Неудивительно, что компания имеет собственные разработки по детектированию дипфейков. В 2022 году «Сбер» получил два патента Федеральной службы по интеллектуальной собственности на «технологии обнаружения синтетического изменения изображений лиц людей в видео». Основу созданного компанией детектора составили нейросетевые модели класса EfficientNet, но, в отличие от Deepware Scanner, они объединены с другой технологией: «методом амплификации и анализа средствами ИИ микроизменений в цветах объектов на кадрах», что, возможно, близко к методу FakeCatcher. Это теоретически позволяет добиться очень высокой достоверности детектирования. Испытания на независимых тестовых выборках показали точность 98 %.

Уникальной особенностью технологии «Сбера» стало то, что она позволяет анализировать видеоконтент, где в кадре находится более одного лица. На сегодня это единственная модель, имеющая такую функцию. Основная направленность, по заявлению разработчика, — защита от кибератак с обходом систем Face Recognition (распознавание лиц) и Liveness Detection*, то есть защита от обмана биометрических систем, а также обеспечение защиты переговоров по видео-конференц-связи. Важность этого именно для «Сбера» очевидна.

* Liveness Detection (проверка живого присутствия) — необходимый компонент систем биометрической идентификации. Позволяет удостовериться, что шаблон для идентификации делается с живого человека, а не с фотографии или иной имитации.

Отражения в глазах

Разработчик: Университет штата Нью-Йорк

Готовность: научная работа представлена в 2021 году, практического применения не зафиксировано

Программисты из Университета штата Нью-Йорк в Буффало разработали оригинальную систему выявления дипфейков. Она применяется для анализа статичных фото, хотя в принципе может быть использована и для покадрового исследования видео.

Разработка имеет достаточно простой принцип работы, основанный на сравнении отражений на роговице глаза. Это сразу ограничивает область ее применения портретными снимками анфас, на которых отчетливо видны глаза. В этом и только в этом случае точность детектирования изображений, созданных генеративно-состязательной нейросетью (Generative adversarial network, GAN), составляет 94 %.

Детектирование основано на том, что на реальной фотографии отражение в обоих глазах будет одинаковым, а у сгенерированного изображения — содержать отличия. ИИ составляет карту лица и анализирует свет, отраженный в каждом глазу. Чем больше процент несовпадения, тем выше вероятность, что изображение поддельное.

Достоинство метода — относительная простота, недостаток — очень узкая сфера применения. Также стоит учитывать, что метод представлен в 2021 году, а с тех пор нейросети ушли далеко вперед и не делают таких очевидных ошибок.

Расхождение звука и видео

Разработчик: Open University of Catalonia (UOC)

Готовность: научная работа представлена в 2020 году, практического применения не зафиксировано

Проект Открытого университета Каталонии Dissimilar демонстрирует еще один подход к выявлению видеоподделок. Система сравнивает аудио- и видеопоток и анализирует такие параметры, как рассинхронизация движения губ и речи, неестественные движения мимических мышц при артикуляции и так далее.

Поскольку многие дипфейки строятся на комбинировании аудио- и видеодорожек из разных источников, метод показывает себя эффективным при детектировании большого процента фейкового контента, например роликов, где публичным лицам приписываются высказывания, которых они не делали.

Эксперименты на датасетах показали, что Modality Dissonance Score имеет эффективность 95 % — но только для узкого сегмента примитивных подделок, где аудиопоток просто накладывается на видео, без коррекции последнего. Технология заявлена в 2020 году, когда нейросети еще не освоили технологию «липсинк» (lip sync) — синхронизацию движения губ и звукового ряда.

Ложные высказывания

Разработчик: Defudger

Готовность: работает

Проект Defudger ставит более широкие цели, чем просто обнаружение манипуляций с видео и статичными изображениями. Решение на базе искусственного интеллекта претендует на комплексный анализ любого цифрового контента на наличие признаков ложной информации. Это включает в себя не только видеодипфейки и поддельные фото, но и верификацию текстовой части.

Изучая различные элементы текста, изображений и видео, алгоритмы Defudger могут выявлять несоответствия и потенциально ложные сведения. Разработчики позиционируют это как универсальное решение для СМИ, которое позволило бы редакциям избежать непроизвольной дезинформации читателей и публикации сомнительных статей.

Defudger проверяет подлинность оригинального контента с использованием технологии блокчейн. Алгоритмы ИИ обнаруживают манипуляции с изображениями и видео, сравнивая их с огромной библиотекой подтвержденного и дезавуированного контента. Проще говоря, основываясь на базе выявленных фейков и подтвержденной фактологии, система выявляет манипуляции с контентом, находя исходники правленых материалов (включая рерайты и коррекции подачи оригинальных новостей), а также указывает на несоответствие материала фактам, считающимися «безусловно достоверными».

Границы и склейки

Разработчик: Пит Рингвуд

Готовность: работает

Метод FotoForensics разработан для судебных экспертов еще в 2010 году. Он не использует ИИ. Технология является глубокой автоматизацией методик практической фотокриминалистики, которую полицейские эксперты с успехом применяли десятилетиями.

В основе метода лежит алгоритм ELA (error level analysis — анализ уровня ошибок), который разработал Нил Кравец в 2007 году. Он построен на том, что изображение, не подвергавшееся постобработке, будет однородным, без ярко выраженных светлых, темных или радужных областей. Если же на фото были добавлены фрагменты с других изображений, это создает невидимые глазу, но доступные компьютерному анализу ошибки — появляются микроартефакты перепада цветности и контрастности. В этом случае фильтр ELA выделит предполагаемые области внесения изменений.

Преимущества сервиса — быстрота работы, открытость и бесплатность. Недостаток — он может выявить только ситуацию «изменение базового изображения путем внесения правок», но в случае полной генерации артефакты такого рода отсутствуют. До появления GAN-сетей основной методикой создания фотофейков была правка в Photoshop, поэтому метод работал. Сейчас — не всегда.

Тем не менее FotoForensics остается полезным для тех, кто работает с пользовательским контентом: редакций, журналистов, фактчекеров и так далее.

Особенности сжатия

Разработчики: разные

Готовность: концепция

Одной из самых сложных задач в детектировании дипфейков является анализ сжатого медиаконтента. Алгоритмы сжатия фото и видео вносят артефакты, затрудняющие различение отредактированных и неотредактированных кадров. Поскольку большинство фейков распространяется не в виде оригиналов, а в формате многократно пережатых роликов (например, при каждом перепосте картинки в соцсетях веб-платформа пересжимает изображение заново), это действительно актуальная проблема.

Концепция детектирования манипуляций на сжатом медиаконтенте включает несколько методик. Первая — анализ векторов движения: векторы используются для сжатия при кодировании движения объектов в видео, и если при анализе выявлено их нарушение, это может быть признаком редактуры.

Вторая — анализ коэффициентов DCT. Речь о коэффициентах дискретного косинусного преобразования, которое используется алгоритмами сжатия видео для кодирования частотного содержимого видеокадра. Если при их анализе обнаруживается резкое изменение частотного содержания между кадрами, это признак подделки.

Третья — анализ артефактов сжатия. Неравномерность их распределения может указывать на различную степень сжатия разных участков кадра, что является признаком монтажа.

Четвертая — машинное обучение: нейросеть обучается на больших массивах как отредактированного, так и неотредактированного видео и впоследствии может отличать одно от другого.

Читайте также, что такое дипфейки и как они устроены:

Использованные источники: Материал опубликован в журнале «Цифровой океан» № 20 (ноябрь-декабрь), 2023, prompted by Fma12, SEBASTIAN KAULITZKI / SPL / Imago / Legion-media, Tetra images / Getty Images, MartinPBGV / iStock.com, Wajeeha Khan / unsplash, Cavan Images / Cavan / Getty Image, Ivan Curra (cc by-sa), AleksandarGeorgiev / iStock.com, AP / East News