Верю не верю Как генеративно-состязательные нейросети (GAN) стали инструментом мошенников

В январе 2020 года управляющему одного из банков в Дубае позвонил директор. Он предупредил, что в почте того ждет запрос на перевод 35 миллионов долларов, подчеркнув, что оплату важного корпоративного приобретения следует одобрить как можно скорее. Что и сделал исполнительный сотрудник. Прежде он не раз общался с директором и сразу узнал его голос в трубке. Но менеджер ошибался: распоряжение отдал вовсе не человек, при этом внушительная сумма стала быстро растворяться в глобальных банковских сетях.

О краже из неназванного арабского банка стало известно только осенью 2021 года, когда в распоряжении журналистов Forbes оказались некоторые документы о расследовании преступления. Этот случай стал вторым зарегистрированным финансовым мошенничеством, совершенным с помощью звукового дипфейка — голоса, ловко подделанного искусственным интеллектом. Такие технологии позволяют имитировать не только речь, но и внешность и даже мимику жертвы, используя чужую личность, словно послушную марионетку.

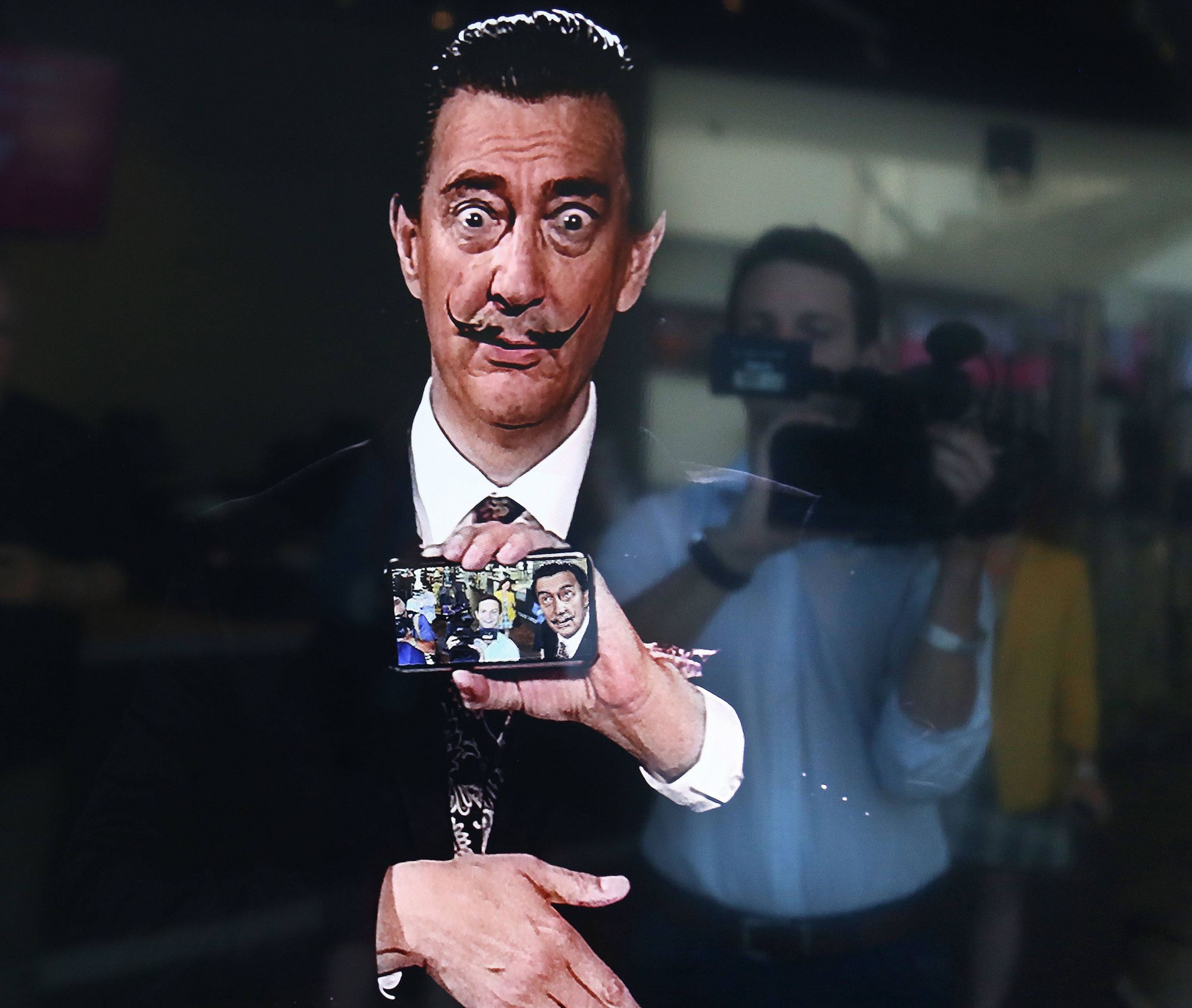

На выставке, посвященной 115-летию Сальвадора Дали, большим успехом пользовалась виртуальная копия великого художника

Эксперты, опрошенные Университетским колледжем Лондона в 2020 году, назвали дипфейки главным и самым актуальным из рисков, связанных с массовым применением ИИ. По уровню опасности, простоте и скорости применения подделка личности обошла даже такие очевидные угрозы, как применение боевых автономных роботов или хакерский перехват управления беспилотным автомобилем. А ведь начиналось все так безобидно — с забавных видеофильтров, позволяющих взглянуть на себя «в старости» или «поменяться» лицами с другим человеком.

Генератор и дискриминатор

Манипуляции с фотоснимками и кинозаписями начались почти одновременно с их появлением на свет. Сперва они производились с помощью хитроумных приемов съемки, затем появились компьютерные спецэффекты. Но до недавнего времени спецэффекты оставались прерогативой больших студий, требуя профессиональных программных пакетов и мощных, дорогих вычислительных систем. Коренные изменения начались в 2014 году, когда на свет появилась новая модель машинного обучения — генеративно-состязательные нейросети (Generative Adversarial Network, GAN).

Нейросеть накладывает трехмерную сетку на лицо актрисы, чтобы заменить его чужим

В такой архитектуре используются одновременно две нейросети, конкурирующие между собой. Первая из них генерирует изображения, речь или другие образцы, а вторая старается отличить удачные от неудачных. У каждого участника этой игры разные цели: у генератора — создать как можно более натуралистичный образец, у дискриминатора — идентифицировать подделку. Соревнуясь, они обучаются вплоть до того момента, когда синтезированное изображение не распознает даже человек.

Главным потребителем алгоритмов GAN считается индустрия развлечений. Нейросети улучшают качество старых кинолент вплоть до уровня 4К, «на лету» повышают разрешение графики в видеоиграх. Звезды экрана появляются в роликах, в которых никогда не снимались. Для этого достаточно сделать запись с дублером, обучить GAN превращать его лицо в нужное актерское, а затем использовать искусственный интеллект для обработки исходного видео. Еще проще обойтись с голосом: имея достаточно записей для подготовки нейросети, можно заставить его произносить что угодно.

Кинобиография Энтони Бурдена «Бегун» вышла три года спустя после смерти знаменитого шеф-повара, сам он появляется на экране в виде дипфейка

Так поступили, например, авторы биографического фильма о популярном в США шеф-поваре и телеведущем Энтони Бурдене, который «озвучивал» закадровый текст, невзирая на то что скончался за год до начала съемок. Технология оказалась настолько простой и доступной, что многие разработчики обещают вскоре «полную демократизацию мира спецэффектов», которая позволит каждому любителю создавать фантастические шедевры. Входной барьер и вправду минимален: в Сети легко найти подробные инструкции по изготовлению дипфейков или заказать работу удаленному фрилансеру, совсем недорого. Но именно поэтому быстро проявилась и обратная сторона технологии, уже отнюдь не развлекательная.

Политики и люди

Первый зафиксированный случай банковского мошенничества с использованием дипфейков произошел в 2019 году, всего через пять лет после появления на свет архитектуры GAN.

Тогда в одну из британских энергетических компаний поступил телефонный звонок из головного офиса в Германии, и голос с узнаваемым немецким акцентом попросил перевести 220 тысяч фунтов на счет третьей фирмы. Лишь случайно, заметив, что звонок сделан с неправильного номера, служащие остановили транзакцию, и схема не удалась.

Первый дипфейк Барака Обамы, распространившийся по Сети в 2018 году, никого не обманул. Но напугал многих

На опасность дипфейков указывает даже ФБР: весной 2021 года бюро выпустило предупреждение о том, что компаниям стоит ожидать всплеска подобных преступлений «в ближайшие 12–18 месяцев». Но мошенников привлекают личности не только крупных бизнесменов, но и политиков. Дипфейк голоса оппозиционера Леонида Волкова использовали известные пранкстеры Лексус и Вован, «поговорив» от его имени с президентом Украины Владимиром Зеленским. Публикация дипфейков с влиятельными политическими фигурами открывает нешуточные возможности для манипуляции общественным мнением. А ведь чем значительнее личность, тем проще собрать базу видеозаписей для обучения GAN.

Впрочем, для имитации лица с приличным качеством хватает и нескольких фотографий, найденных в социальных сетях. Поэтому до сих пор главными жертвами дипфейков остаются самые обычные люди, прежде всего женщины, внешность которых «накладывается» на чужие записи 18+ с целью шантажа, из зависти или мести. Согласно отчету Deeptrace, 96 % размещенных в сети дипфейков относится к непристойным. Только на четырех крупнейших сайтах, публикующих фальшивое видео для взрослых, эксперты насчитали больше 134 миллионов роликов, как со знаменитостями, так и с самыми рядовыми людьми.

Нейросети GAN активно используются приложениями для наложения видеофильтров, включая «омолаживание» или замену лица

Этот процесс можно даже полностью автоматизировать. Не так давно власти Китая задержали жителей Шанхая, которые массово скупали базы с фотографиями граждан КНР. «Оживляя» их с помощью нейросети GAN и пользуясь одноразовыми телефонами, преступники обманывали систему распознавания лиц в приложении налоговой инспекции, чтобы регистрировать компании-однодневки и выписывать поддельные накладные. Недалек тот день, когда и российские телефонные мошенники начнут массово «клонировать» голоса для звонков родственникам с просьбами срочно перевести деньги.

Действие и противодействие

Нельзя сказать, что этой угрозе совсем нечего противопоставить. Чем реалистичнее становятся дипфейки, тем интереснее находить способы их распознавания, и за последние годы появилось немало подобных инструментов. Система Microsoft Video Authenticator обнаруживает незаметные для человеческого глаза детали, выдающие поддельную видеозапись, например участки неточной «склейки» на границе между лицом и фоном. А исследователи из Университета Нью-Йорка обнаружили, что такое изображение можно определить по неправильной форме зрачков, которые на дипфейках редко получаются округлыми.

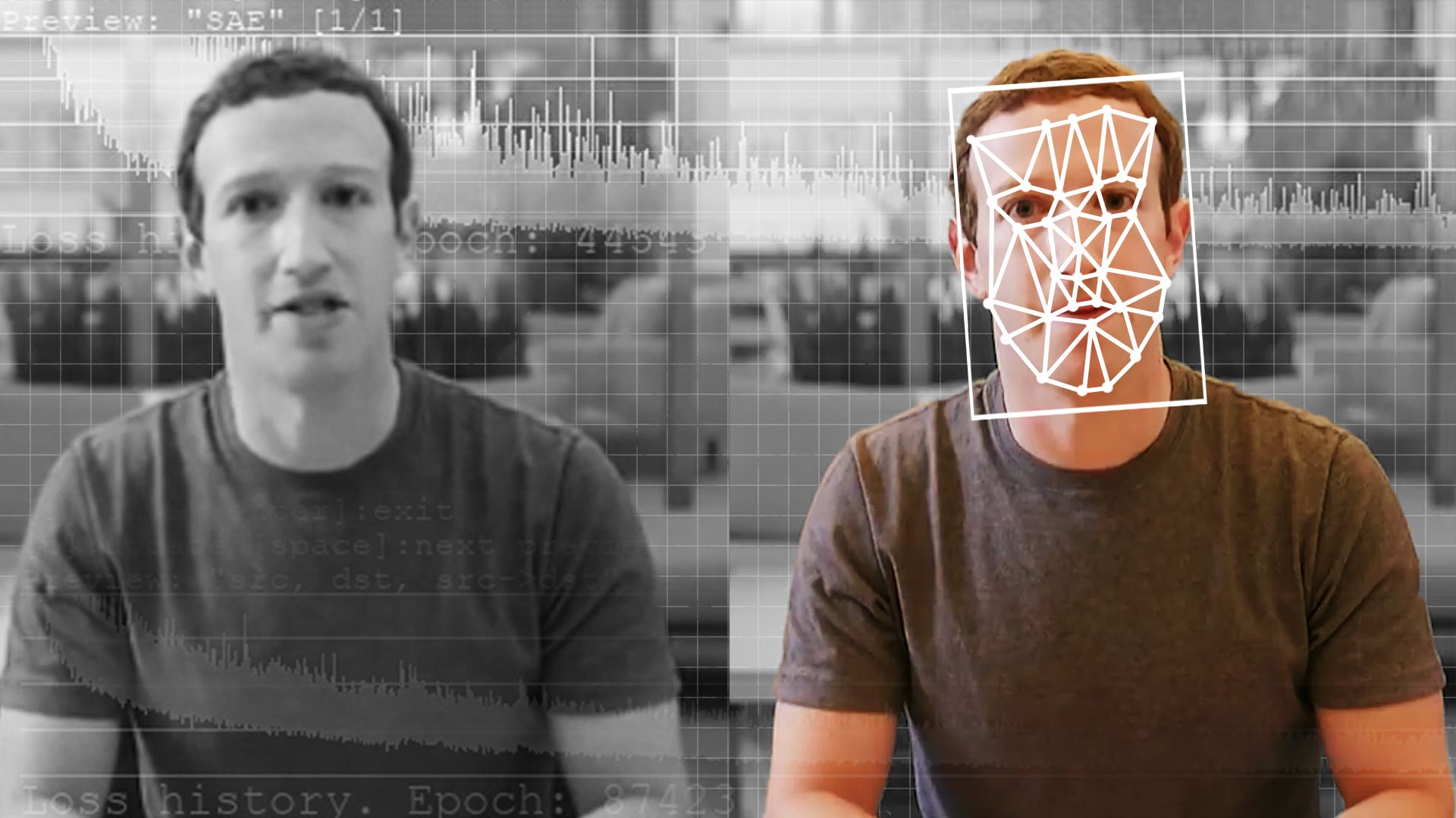

В известном дипфейк-видео глава Facebook Марк Цукерберг рассуждает о тотальном контроле над данными и жизнями миллиардов людей

Можно ожидать, что уже в скором времени подобные функции будут встраиваться в приложения и сайты, социальные сети и сервисы видеохостинга, позволяя «на лету» идентифицировать поддельную запись и даже голос. Но пока одни разработчики будут находить все новые и новые средства определения дипфейков, другие постараются их нейтрализовать, одно за другим. В Сети уже появились инструменты, дополнительно округляющие зрачки на поддельных видеороликах. Находятся пути противодействовать и другим способам идентификации подделок, так что угроза вряд ли исчезнет в обозримом будущем.

В любой гонке вооружений лидирующую активную роль играют средства нападения, а защита лишь следует за ними, закрывая возникающие бреши. Видимо, так произойдет и на этот раз. Подделки будут обгонять инструменты их обнаружения на несколько шагов и постоянно совершенствоваться — вплоть до момента, который некоторые обозреватели называют дипфейк-сингулярностью. Эксперты опасаются, что качество и количество имитаций в конце концов достигнут такого уровня, при котором у нас не будет никакой возможности их идентифицировать. Не останется уверенности в истинности любых утверждений, никаких надежных фактов. И мы окончательно окажемся в матрице подделок, которую создали сами.

Читайте также детективную историю о том, как хакерский взлом закончился арестом криминальных авторитетов:

Использованные источники: Материал опубликован в журнале «Цифровой океан» № 9, 2022, alphaspirit.it / Shutterstock / Fotodom, Scott Keeler / ZUMA Wire / Legion-media, ©Focus Features / Courtesy Everett / Legion-media, Opturadesign / Alamy / Legion-media, AP / East News, Reuters TV / REUTERS / Pix-stream, Elyse Samuels / The Washington Post / Getty Images