Переселение душ Решатся ли IT-компании «воскрешать мертвых», как в сериале «Черное зеркало»

Кроме платного хранения данных коммерсанты могут предложить что-то поинтереснее — например, цифровую копию реально существовавшего человека, которая утешит тех, кому его не хватает. Благодаря сериалу «Черное зеркало» мы смогли хорошо представить себе мир, населенный имитированными личностями. В конце 2020 года фантазии стали воплощаться в реальность: компания Microsoft запатентовала технологию чат-бота, который может скопировать личность любого человека. В том числе погибшего.

Похожую услугу предлагали и раньше, правда, это были не технологические гиганты вроде Microsoft, а небольшие стартапы. В начале 2016 года бывший главред сайта «Афиша» Евгения Куйда и специалист в области компьютерной лингвистики из МГУ Филипп Дудчук анонсировали проект Replika. Пользователям предлагалось общаться с ботом, который обучался и вскоре начинал копировать черты своего собеседника. Со временем личного клона можно было начать использовать для коммуникации с другими людьми или даже оставить им на память. Но проект оказался не очень востребованным, и его авторы отказались от концепции двойника. Сейчас Replika предлагает цифровых друзей для тех, кому одиноко.

Проект Replika

Регистрация патента Microsoft наделала гораздо больше шума. Пользователи Twitter писали, что затея повторяет серию с цифровым воскрешением из «Черного зеркала» и поэтому выглядит жутко, а СМИ задались вопросом, как скоро антиутопия может стать реальностью.

, специалист по разговорным интерфейсам. Возглавлял компании «Лаборатория наносемантика» и Essential Commerce, а также Центр искусственного интеллекта МТС. Курировал разработку «умной колонки» и голосового помощника «Марвин» от МТС:Применимость идеи широкая, и вовсе не обязательно копировать умерших. Нейросеть может выступать имитацией усопшего дедушки, а может быть оператором контактного центра или секретарем бизнесмена. Например, я не против сделать цифровую копию себя и добавлять этого бота в некоторые моменты коммуникации, где мое присутствие не обязательно

Прабабушка ботов

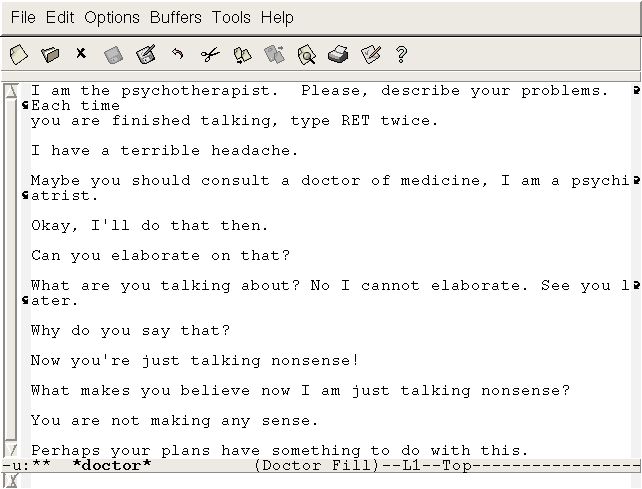

Первый виртуальный собеседник появился даже не 10–20 лет назад, а еще в 1966 году. Бот Элиза был создан американским ученым Джозефом Вейценбаумом как эксперимент. Программа пародировала общение психотерапевта с клиентами, задавая собеседнику вопросы и анализируя ответы по ключевым словам. Выбор роли был продиктован тем, что в таком диалоге можно вместо ответа задавать встречный вопрос и при этом не выглядеть странно.

Бот Элиза

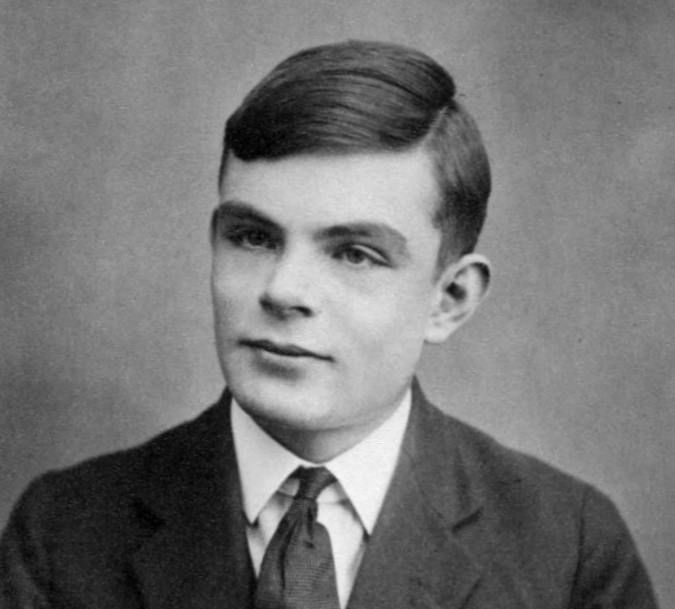

Система оценки мастерства общения для роботов появилась даже раньше. Идею в 1950 году опубликовал математик Алан Тьюринг в журнале Mind: «Испытатель взаимодействует с одним компьютером и одним человеком. На основании ответов на вопросы он должен определить, с кем разговаривает: с человеком или компьютерной программой. Задача компьютерной программы — ввести испытателя в заблуждение, заставив сделать неверный выбор». По некоторым версиям, первая программа, которая справилась с тестом, — как раз Элиза. Ей удавалось вводить людей в заблуждение, хотя эксперимент не был чистым: перед началом испытуемым говорили, что с ними будет общаться живой человек.

Примитивный инструмент

Тест Тьюринга широко используется и сегодня, прежде всего на конкурсе искусственного интеллекта AI Loebner, который с 1990-го проводится ежегодно. Последние четыре года его выигрывал чат-бот Mitsuku, его признают наиболее «человечным» среди всех участников. Любой желающий может это проверить, пообщавшись с Mitsuku в интернете. При первой же проверке окажется, что бот не так уж и умен: он воспринимает только грамотную речь, не помнит контекста беседы, легко теряет нить разговора. Но как же тест Тьюринга?

, специалист по разговорным интерфейсам:Конечно, Элиза никак не могла быть по-настоящему похожа на психотерапевта. Реальный специалист не просто задает вопросы и следует правилу пяти „почему“, а профессионально ведет клиента к нахождению ответов на вопросы. И этот пример отражает вообще всю историю работы над нейросетями. Даже самая продвинутая на сегодня программа не может сравниться с разумным существом

Пройти его не очень сложно, как может показаться: на ограниченном отрезке времени собеседник не должен заподозрить, что говорит с роботом. Получается, что коммерческие системы обслуживания клиентов проходят этот тест тысячи раз в сутки. Конкурс Лёбнера — более сложное испытание, но смысл остается тем же: с помощью теста Тьюринга оценивается владение языковым инструментарием, уровень имитации. Сегодня не существует технологии, которая генерировала бы ответы осмысленно.

Алан Тьюринг

Точка невозврата

Однако специалисты допускают, что это не навсегда. Они предлагают термин «точка технологической сингулярности» для обозначения момента, когда искусственный интеллект осознает себя как личность. Никто не может сказать, в какой момент это произойдет и как тогда повернется история. Также мы не способны вычислить, что это вообще произошло: неожиданное действие может быть вызвано какой-то ошибкой, а может быть и мотивированным шагом.

, специалист по разговорным интерфейсам:Для человека лексикон — это отражение его сознания, поэтому в любом общении происходит какая-то трансформация, присутствует динамика. А у машинок нет сознания: лексикон — это все, чем они владеют. Их работа похожа на хаотично летающие по лесу топоры: они точно порубят деревья, но что на самом деле нужно рубить и в какую сторону валить лес, знают только люди

Сегодня вершина сложности подобных систем — программа GPT‑3 компании OpenAI. Программа стала доступна в 2020 году и уже успела многих удивить. В течение недели нейросеть прикидывалась человеком на ресурсе Reddit: писала большие осмысленные комментарии. Ее рассекретили из-за огромной скорости публикации текстов. А еще GPT‑3 написала колонку для The Guardian: «Я знаю, что мой мозг — это „не чувствующий мозг“. Но он может принимать рациональные, логические решения. Я научилась всему, что я знаю, просто читая интернет, и теперь могу написать эту колонку. И у меня еще много идей!» Хотя GPT‑3 говорит о себе так, будто способна на мыслительный процесс, эксперты настаивают: нейросеть может очень убедительно составлять предложения, но это не имеет ничего общего с настоящей генерацией смыслов.

, специалист по разговорным интерфейсам:Несколько лет назад произошел интересный случай: в системе управления вентиляцией на станции метро применили нейросеть. Для обучения поставили камеру, на которой шла запись происходящего на платформе. Программисты ориентировались на количество людей на станции и думали, что нейросеть обучится так же. И система действительно заработала, прекрасно управляла вентиляцией, а потом вдруг выключила ее и больше не включала. Стали разбираться и выяснили, что нейросеть ориентировалась не на пассажиропоток, а на часы напротив камеры. И как-то ночью они перестали ходить. Особенность нейросетей в том, что не всегда ясно, на какие данные они опираются при обучении

Становится жутко

Но общество интересуется не столько технической стороной вопроса, сколько этической и философской. Людей пугают антропоморфные технологии, и первым об этом заговорил японский ученый Масахиро Мори. В 1978 году он провел опрос, в котором исследовал эмоциональную реакцию людей на роботов. Поначалу чем больше машина была похожа на человека, тем приятнее казалась, но до определенного предела: самые антропоморфные роботы оценивались как резко отталкивающие. Этот спад «симпатии» был назван «зловещей долиной». Исследователь Минсу Кан в 2009 году предположил, что такие роботы вводят человека в состояние когнитивного диссонанса и сталкивают с неизвестностью: чего именно ждать от такого существа, управляем ли мы ситуацией? В колонке для The Guardian программа GPT‑3 очень много говорит о том, что не станет вредить человечеству. И это только подтверждает актуальность повестки.

В описании патента Microsoft говорилось, что «Цифровой двойник будет соответствовать разным субъектам копирования, неважно — из прошлого они или из настоящего. Так, искусственный интеллект сможет имитировать друга, родственника, знаменитость, вымышленного персонажа или историческую личность». И обществу это не понравилось. После негативной реакции генеральный менеджер программ искусственного интеллекта в Microsoft Тим О’Брайен в своем Twitter добавил, что идея пока останется на уровне патента. В ближайшее время Microsoft не планирует создавать цифровые копии.

, специалист по разговорным интерфейсам:Возможно, в будущем все произойдет как в кино „Газонокосильщик“: достигший осознанности робот расплодится по всем сетям и самовоспроизведется на каждом устройстве. Тогда останется лишь вопрос его мотивации, а о ней мы ничего не знаем. Может быть, этот робот станет новой силой, которая влияет на нашу реальность. Поэтому страх вполне объясним

Когда мы работали над материалом, нам захотелось пересмотреть самые зловещие фильмы о странностях искусственного интеллекта. Вот, что мы посмотрели:

Использованные источники: Материал опубликован в журнале «Цифровой океан» № 6, 2021, GPL, https://commons.wikimedia.org/w/index.php?curid=2236326,